DeepSeek-R1: 강화학습을 통한 추론 능력 고취

링크: https://arxiv.org/abs/2501.12948

연구목적: SFT없이 강화학습만으로 LLM추론 능력을 향상시킬 수 있는지 탐구

데이터셋: 약 800K 개의 샘플 (600K 추론, 200K 비추론)

주요결과: Pure RL만으로 추론 능력 발현을 보임, DeepSeek-R1, Distillation

저자: DeepSeek-AI

DeepSeek-R1은 대규모 언어 모델(LLM)에 강화학습(RL)을 적용해, 모델이 스스로 ‘Reasoning’ 능력을 발달시키도록 유도한 연구이다. 본 연구에서는 DeepSeek-R1-Zero와 DeepSeek-R1이라는 두 가지 모델을 단계적으로 제안하며, 이후 지식 증류(Distillation)를 통해 소형 모델에서도 강력한 추론 능력을 발휘할 수 있게 한다. 수학, 코딩, 논리적 추론 등 체계적 문제에서 뛰어난 성능을 보이며, 궁극적으로 OpenAI의 o1-1217(일명 ChatGPT-4o 시리즈의 고급 버전)과 유사한 추론 성능을 달성하였다.

연구 배경

최근 LLM 연구에서는 사전학습(Pre-training) 이후 후처리(Post-training)를 통해 성능을 높이는 방식을 주로 사용한다. 기존에는 Supervised Fine-Tuning(SFT)을 거친 뒤, 추가적인 RL을 적용해 모델을 더 정교화하는 방식이 일반적이었다.

DeepSeek-R1 연구진은 다음과 같은 질문에서 출발했다.

“SFT 없이 순수 RL만으로도 추론 능력을 발전시킬 수 있을까?”

이에 대한 해답으로 DeepSeek-R1-Zero 모델을 통해, 자동화된 규칙 기반 보상만으로 독자적 추론 능력을 개발할 수 있음을 보였다. 하지만 이 방식은 가독성과 언어 혼합 문제가 있어, Cold-start 데이터를 추가로 활용한 개선 모델인 DeepSeek-R1을 제안하였다.

Main Contribution

이 연구의 두 가지 주요 기여는 다음과 같다:

1. 순수 RL 기반 추론 모델: DeepSeek-R1-Zero

- Supervised Fine-Tuning(SFT) 없이, Base Model에 직접 강화학습(RL)을 적용해 추론 능력을 개발.

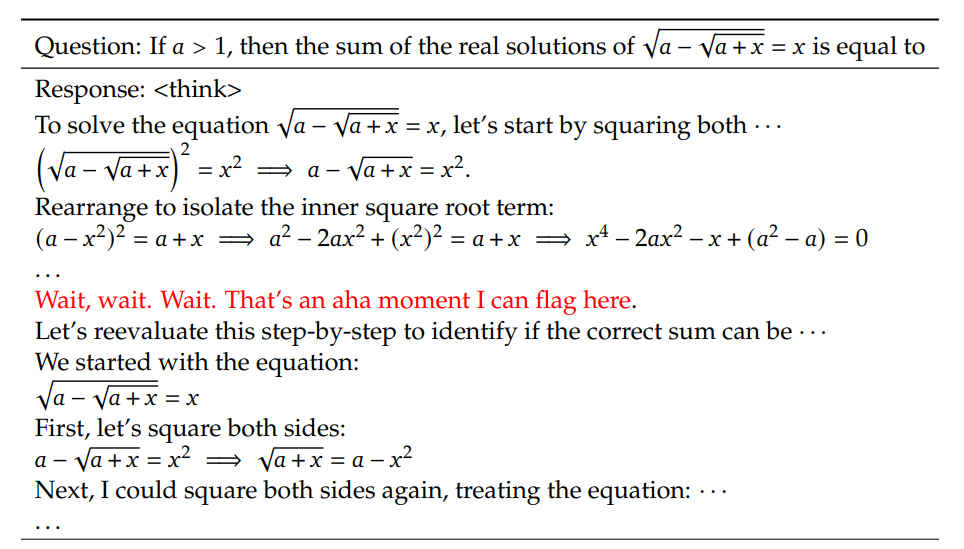

- Chain-of-Thought(CoT) 기반 학습을 통해 수학, 코딩 등 복잡한 문제를 해결하는 과정에서 자기 검증(self-verification), 반성(reflection), ‘아하!’ 모멘트(insightful realization) 등 인간과 유사한 고차원적 사고 행동이 자발적으로 나타남.

- 인간 피드백 없이도 스스로 학습 경로를 찾는 능력이 강화되면서, 지도 데이터 의존도를 크게 줄임.

2. 멀티 스테이지 학습 전략: DeepSeek-R1

- Cold-start 데이터를 활용해 모델을 가볍게 미세 조정한 후, 추론 중심의 RL을 적용해 언어 혼합, 비문 등 실제 사용에서의 문제를 개선.

- RL을 통해 생성된 고품질 결과물을 다시 SFT 학습 데이터로 활용하여, 추론력과 언어 표현력을 동시에 강화.

- 모든 시나리오를 고려한 추가 RL 단계를 거쳐 최종 모델 성능을 극대화함.

- 이 과정을 통해 필요한 컴퓨팅 자원과 학습 비용을 대폭 절감하면서도 기존 대형 모델에 견줄 만한 성능을 달성.

DeepSeek-R1 학습 구조

DeepSeek-R1의 학습 과정은 다음과 같은 단계로 구성된다:

1. Cold-Start 단계

- 미리 준비된 긴 Chain-of-Thought(CoT) 데이터로 기초 모델(DeepSeek-V3-Base)을 미세 조정.

2. 추론 중심 강화학습(RL) 단계

- Group Relative Policy Optimization(GRPO)를 사용하여 정확성과 형식 보상을 기반으로 추론 성능 강화.

3. Negative Sampling 및 SFT

- RL 결과 중 우수한 데이터만 선별하여 새로운 SFT 데이터로 활용.

4. 최종 RL 학습

- 추론 외에도 일반 작업에서 유용성과 안전성을 동시에 높이는 추가 RL 과정.

Cold-Start SFT (DeepSeek-R1에만 적용)

DeepSeek-R1-Zero는 전혀 SFT 없이 순수 RL만을 이용해 모델의 추론 능력을 개발하는 반면, DeepSeek-R1은 매우 소량의 Cold-Start 데이터를 이용한 SFT로 초기 모델을 정교화한 뒤 강화학습(RL)을 시작한다. 이 Cold-Start 데이터는 사람이 읽기 쉬운 코멘트와 긴 CoT(Chain-of-Thought)를 포함하며, 이를 통해 모델의 초기 출력 가독성을 높이는 효과를 얻는다.

| 모델 이름 | SFT 여부 | RL 여부 | 특징 |

|---|---|---|---|

| DeepSeek-R1-Zero | X (전혀 사용 X) | O (순수RL) | 순수 RL로만 모델의 추론능력을 발전시키는 접근법 |

| DeepSeek-R1 | O (소량의 Cold-start SFT) | O (RL) | 초기 소량의 SFT로 가독성을 높이고, RL로 성능을 추가 개선 |

- 정답만 맞추는 것이 아니라, 명료한 언어와 요약 중심의 출력을 강조하여 가독성을 향상한다.

- 특히 수학이나 코딩 문제의 경우 논리적 전개 과정과 최종 결론을 명확히 드러내도록 설계된다.

흥미로운 발견: DeepSeek-R1-Zero의 ‘Aha Moment’

DeepSeek-R1-Zero 모델이 훈련 중 겪은 **’Aha Moment’**는 특히 주목할 만한 발견이다. 이는 모델이 문제 해결 과정에서 스스로 더 긴 사고 시간을 할애하고 초기 접근 방식을 재검토하는 행동을 자발적으로 보여주는 현상이다. 이 과정에서 모델은 마치 사람처럼 자신의 오류를 인지하고 더 나은 해결책을 모색하며, 강화학습(RL)이 명확한 지침 없이도 적절한 인센티브만으로 모델의 자율적이고 정교한 추론 전략을 효과적으로 발전시킬 수 있음을 증명하였다.

성능 결과 요약

DeepSeek-R1은 다양한 벤치마크에서 뛰어난 성능을 입증하였다:

- 수학 (AIME 2024): Pass@1 기준 79.8%, OpenAI의 o1-1217보다 우수한 성능.

- 코딩 (Codeforces): 상위 96.3% 전문가급 성능 달성.

- 일반 지식 및 추론 (MMLU, GPQA Diamond): 기존 모델 대비 우수한 결과.

특히, 강화학습을 통한 체계적 문제 해결에서 뛰어난 성능을 발휘하였다.

Distillation을 통한 소형 모델 강화

DeepSeek-R1의 지식을 작은 모델(Qwen, Llama 등)에 distillation하여 전달하는 실험 결과는 매우 성공적이었다. 이를 통해 소형 모델이 별도의 RL 과정 없이도 우수한 추론 성능을 달성하였고, 특히 Distill-Qwen-32B 모델은 동급 모델 대비 월등한 성능을 기록하였다.

연구의 한계점 및 향후 연구 방향

연구진은 다음과 같은 한계와 향후 연구 방향을 제시하였다:

- 다중 언어 지원 및 언어 혼합 문제 개선

- 소프트웨어 엔지니어링 관련 작업 평가 및 향상

- 프로세스 기반 보상 모델과 몬테카를로 트리 탐색(MCTS) 접근법 효율성 향상